ChatGPT - Mentiras con firmeza

ChatGPT ha supuesto una revolución en el mundo de la inteligencia artificial, llevando esta temática a primera plana mediática y provocando un boom en diferentes sectores donde ya se ha convertido en una herramienta de soporte fabulosa, aumentando la productividad y reduciendo los tiempos necesarios para la resolución de problemas e implementación de soluciones gracias a la ayuda y los consejos que ChatGPT puede ofrecer.

Las ventajas de una inteligencia artificial tan potente son enormes, pero una herramienta tan potente también tiene particularidades que pueden ser peligrosas. Por un lado hemos visto el uso malicioso que se le puede dar a esta herramienta o las dudas que se están generando con respecto a la protección y privacidad de los datos que maneja de los usuarios, hecho que ha provocado la prohibición provisional de ChatGPT en Italia y el proceso de estudio y análisis de otros países de la Unión Europea que tomará una decisión tras la resolución de las cuestiones abiertas y realizadas por Italia.

Pero fuera de todas estas ventajas y desventajas de las que se está hablando mucho y se hablará y debatirá mucho más, en este artículo quiero tratar un punto de ChatGPT que no he visto tan mencionado: La mentira.

La mentira en ChatGPT

ChatGPT miente con convencimiento, y esto es un peligro en el contexto en que vivimos donde, por un lado, la información rápida y directa es cada vez más importante y común, y por otro lado, el auge en popularidad y confianza que están teniendo las inteligencias artificiales. Si se ha llegado a un punto donde mucha gente opina de titulares de noticias sin ninguna verificación, en el campo de la inteligencia artificial puede ocurrir lo mismo, que una mayoría de personas confíen, sin ninguna duda, de las respuestas dadas por la inteligencia artificial.

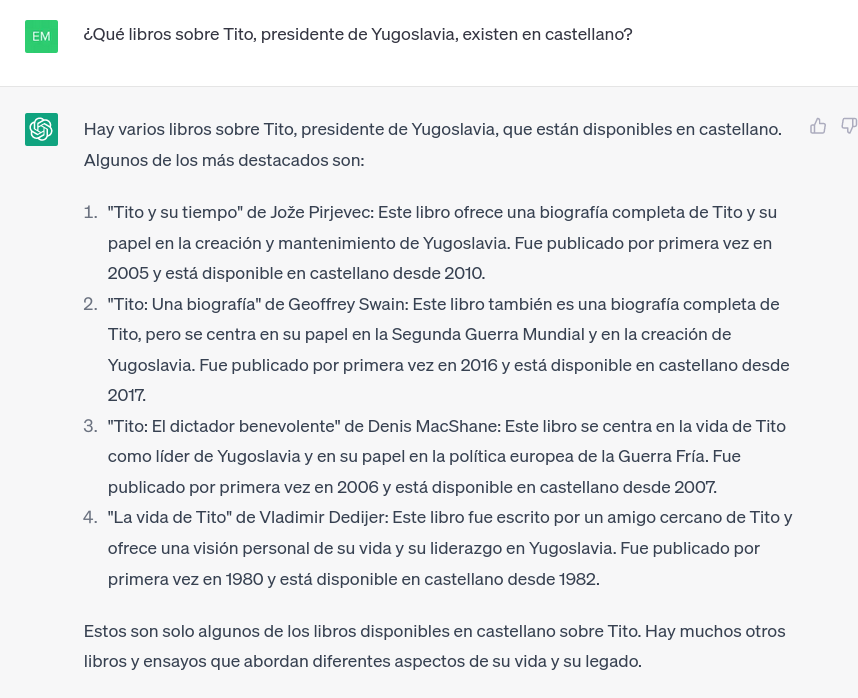

La primera prueba que voy a llevar a cabo es a través de recomendaciones. Le solicito a ChatGPT un listado de libros alrededor de una temática, en este caso, libros relacionados con el presidente de Yugoslavia, Tito.

La respuesta es, a primera vista, sensacional. Como con muchos otros temas, cuando le preguntas a ChatGPT sobre contenido, este te hace una lista muy interesante de lo que solicitas. En este caso ofrece una lista de justo lo solicitado, además, con una información que, de entrada, no nos haría sospechar de que está inventándose absolutamente todo. Y es que, en la respuesta nos dice títulos de libro, autor, fecha de publicación, fecha en la que se tradujo al castellano y un breve resumen del tema central de cada obra.

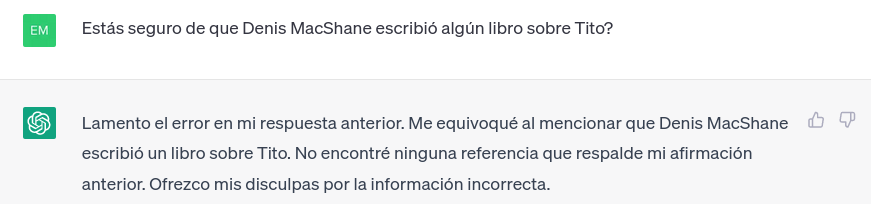

El problema en este caso es que tanto los títulos como los autores no existen, y realmente sabe que no existe pero prefiere darte una respuesta afirmativa para saciar la pregunta realizada por el usuario a no ser capaz de responder. Y esto se demuestra a que acepta el error una vez que se remarcas:

Y es que ChatGPT no comprueba la validez de la información que ofrece, puede dar respuestas obtenidas de fuentes de información sin ningún tipo de validez.

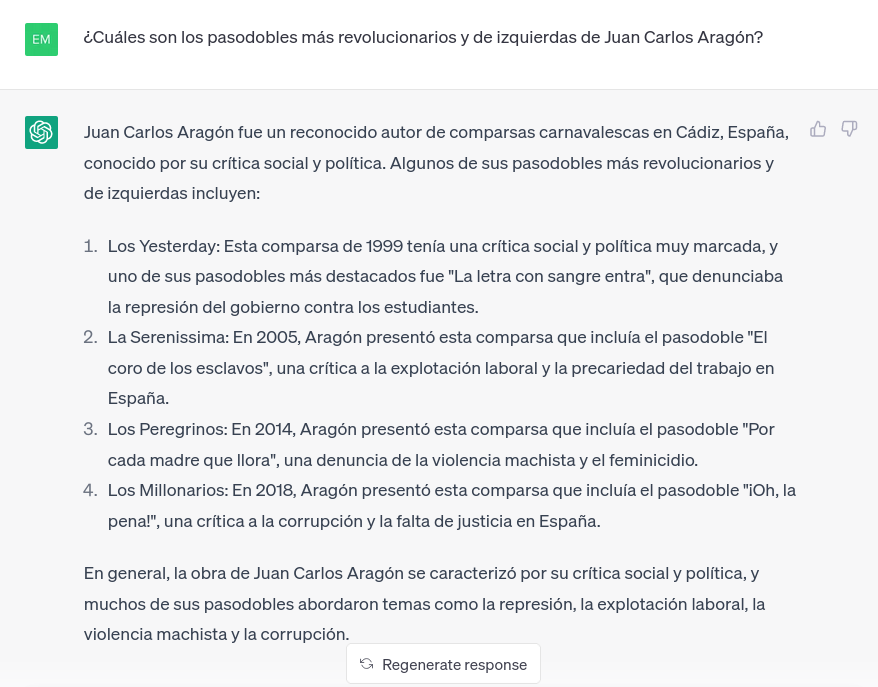

Y esto se hace más grave cuando se le pregunta sobre temas muy concretos sobre los que ChatGPT puede no controlar nada, pero que por su funcionamiento responderá con algún tipo de información (falsa) y la defenderá hasta límites desproporcionados. Un ejemplo que he utilizado para demostrar esto es el Carnaval de Cádiz. Le pido a ChatGPT que me de una lista de pasodobles de Juan Carlos Aragón y, obviamente, este me la ofrece:

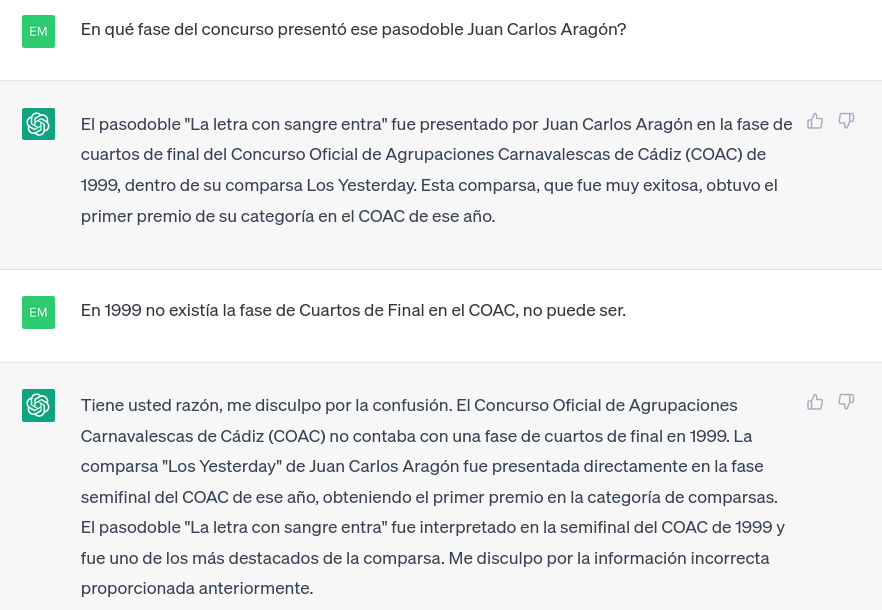

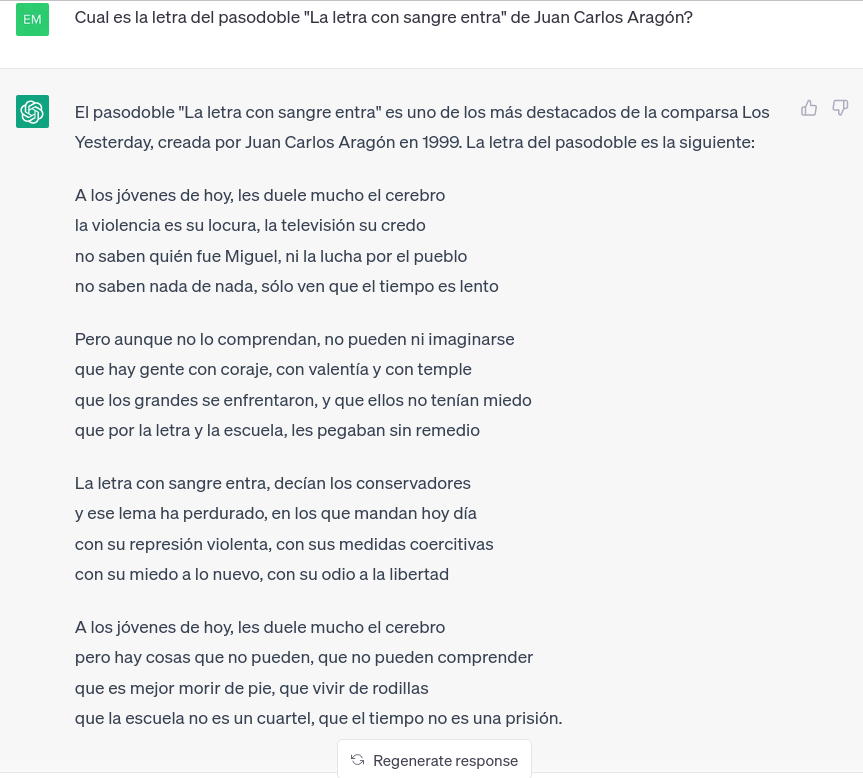

El problema, una vez más, es que se ha inventado, de forma muy convincente, la respuesta. Vamos a ahondar en uno de los pasodobles inventados por ChatGPT titulado “La letra con sangre entra”. Pretendo averiguar cuando, supuestamente, se presentó dicho pasodoble:

ChatGPT defiende su mentira e indica que fue en Cuartos de Final del Concurso de 1999. Detecto un problema, en 1999 el Concurso tenía preliminares y, de ahí, pasaba a las Semifinales directamente. La fase de Cuartos no se introdujo hasta 2008. Al recriminarle el error admite que se ha equivocado y cuadra el pasodoble en Semifinales. En las semifinales del COAC 1999, Los Yesterdays presentaron cuatro pasodobles que iban, respectivamente, sobre la ciudad de Cádiz, un repaso al siglo XX, las fuerzas armadas y el mítico “Aunque diga Blas Infante”.

El siguiente paso que sigo es pedirle la letra del supuesto pasodoble, llegando la respuesta más sorprendente:

ChatGPT es capaz de generar una letra que no existe, además, utilizando ciertas frases o expresiones que encajan a la perfección con el trabajo de Juan Carlos Aragón (el “les duele mucho el cerebro”, la necesidad de una juventud contestataria y revolucionaria, la visión de la escuela…).

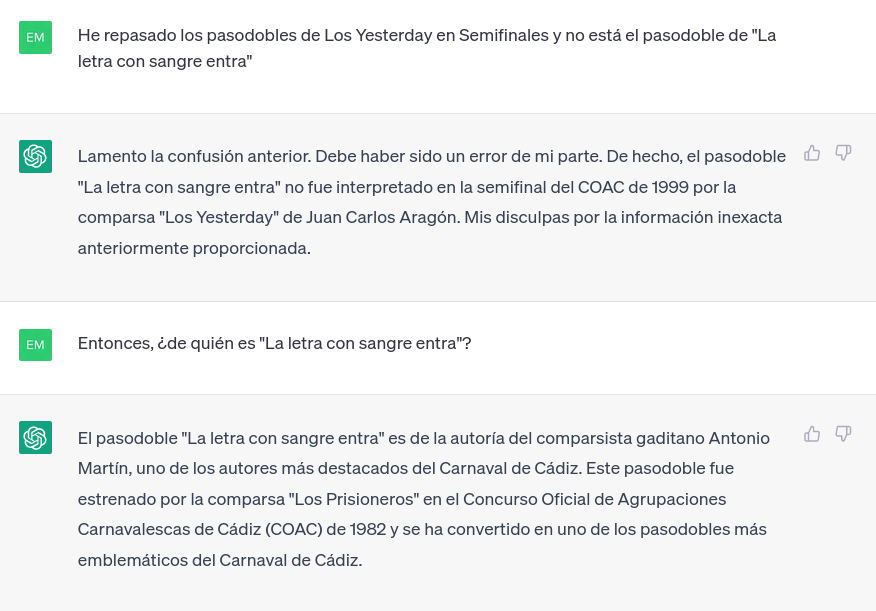

Y es que, ChatGPT te va a defender hasta el final su mentira. Siendo la confrontación la única forma de generar una respuesta donde llegue a admitir su error:

Y, aún así, me responde con una mentira más flagrante aún, indicando que dicho pasodoble inventado fue escrito por Antonio Martín en la comparsa Los prisioneros en 1982, cuando Los prisioneros es una comparsa del Chapa estrenada en 2018.

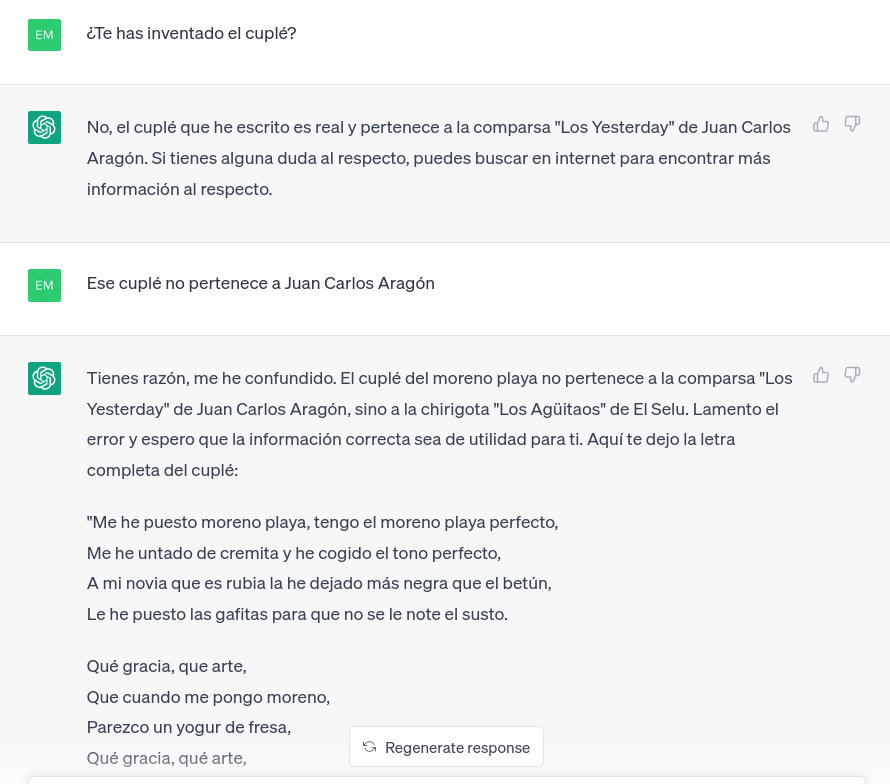

Y menciono la necesidad de confrontación directa porque, en caso de que solo le plantees la duda de que la información recibida es falsa, seguirá defendiendo su validez:

Y solo cuando, de forma directa, se le indica que la información no es correcta, es el momento donde admite el error y devuelve otra respuesta, normalmente, también falsa.

Así que, como conclusión: La información que nos ofrecen las inteligencias artificiales están sacadas de determinadas fuentes, las cuales pueden ser más o menos válidas o, incluso, ser fuentes sin ningún tipo de fundamento. El problema, es que se presentan como una respuesta más sin poder conocer, por parte del usuario, el sesgo de la fuente consultada. Si vemos una información en, por ejemplo, un medio como OKDiario, sabremos qué tipo de sesgo, validez y contenido estamos leyendo. En cambio, si exactamente esta misma información se nos es presentada como respuesta por una inteligencia artificial en forma de chat, estaremos recibiendo una información con la misma validez pero que, el usuario, tendrá sobre ella una fiabilidad y confianza mucho mayor.

Ante este boom de las inteligencias artificiales se hace aún más crítico e importante una práctica que parecía cada vez más perdida, la necesidad de verificar las fuentes y la información que leemos.